robots.txt – מה זה

מהו robots.txt?

קובץ robots.txt מגביל זחלני רשת, כמו בוטים של מנועי חיפוש, מגישה לכתובות URL ספציפיות באתר. בנוסף, ניתן להשתמש בו להתאמת מהירות הזחילה של חלק מהזחלנים.

כל זחלני הרשת (קרולרים / רובוטים / בוטים ) ה"טובים" מצייתים לכללים המצוינים בקובץ robots.txt. עם זאת, קיימים זחלנים "רעים" ולא רשומים, שלרוב משמשים למטרות גרידה (scraping), שמתעלמים לחלוטין מקובץ robots.txt.

יש להשתמש בקובץ robots.txt להפחתה/אופטימיזציה של תנועת הזחלנים באתר ולא לשליטה על אינדוקס דפי האינטרנט. אפילו אם URL אינו מותר בקובץ robots.txt, הוא עדיין יכול להיות מאונדקס על ידי Google אם הוא מתגלה דרך קישור חיצוני.

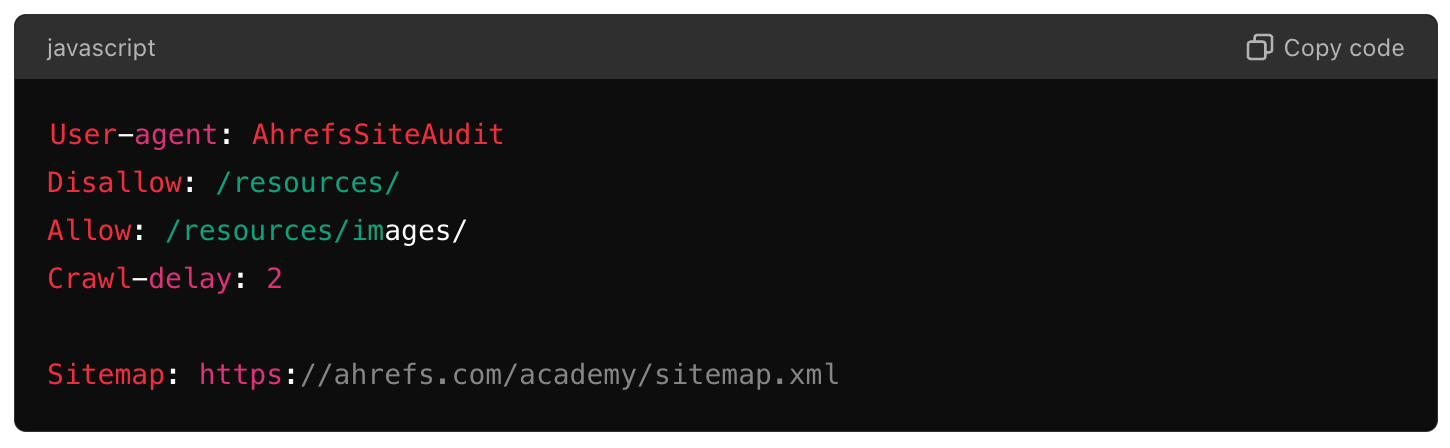

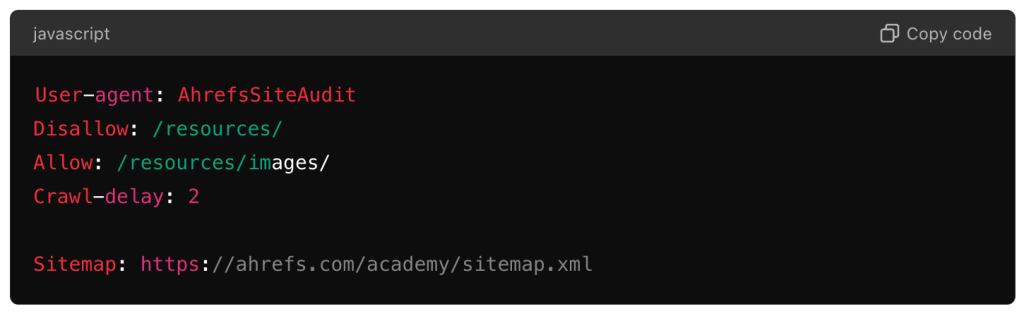

תחביר קובץ robots.txt מכיל את השדות הבאים:

user-agent: הזחלן שהכללים חלים עליו

disallow: נתיב שאסור לזחול

allow: נתיב שמותר לזחול (אופציונלי)

sitemap: מיקום קובץ ה-sitemap (אופציונלי)

crawl-delay: שולט במהירות הזחילה (אופציונלי ולא נתמך על ידי GoogleBot)

דוגמה:

דוגמא לקובץ robots.txt | seo-up קידום אתרים

למה קובץ robots.txt חשוב?

קובץ robots.txt חשוב כי הוא מאפשר למנהלי אתרים לשלוט בהתנהגות הזחלנים באתר שלהם, לבצע אופטימיזציה לתקציב הזחילה ולהגביל את זחילת חלקי האתר שאינם מיועדים לגישה ציבורית.

בעלי אתרים רבים בוחרים להשתמש בתג "noindex" לדפים כמו דפי מחברים, דפי כניסה או דפים בתוך אתר חברות. הם יכולים גם לחסום את הזחילה והאינדוקס של משאבים מגודרים כמו קובצי PDF או סרטונים הדורשים הרשמה בדוא"ל כדי לגשת אליהם.

שווה לציין שאם אתם משתמשים במערכת ניהול תוכן (CMS) כמו WordPress, דף הכניסה /wp-admin/ נחסם אוטומטית מאינדוקס על ידי הזחלנים.

עם זאת, חשוב לציין ש-Google אינה ממליצה להסתמך רק על קובץ robots.txt לשליטה על אינדוקס הדפים. אם אתם מבצעים שינויים בדף, כמו הוספת תג "noindex", ודאו שהדף אינו חסום ב-robots.txt. אחרת, Googlebot לא יוכל לקרוא אותו ולעדכן את האינדקס שלו בזמן.

שאלות נפוצות

מה קורה אם אין לי קובץ robots.txt?

רוב האתרים לא חייבים שיהיה להם קובץ robots.txt. מטרת קובץ robots.txt היא להעביר הנחיות ספציפיות לבוטים של החיפוש, אך זה לא בהכרח נחוץ אם יש לכם אתר קטן או כזה שאין בו הרבה דפים שאתם צריכים לחסום מזחלני החיפוש.

עם זאת, אין חיסרון ביצירת קובץ robots.txt ושמירתו באתר שלכם. זה יקל על הוספת הנחיות במידת הצורך בעתיד.

האם ניתן להסתיר דף ממנועי חיפוש באמצעות robots.txt?

כן. הסתרת דפים ממנועי חיפוש היא אחת מהפונקציות העיקריות של קובץ robots.txt. ניתן לעשות זאת באמצעות הפרמטר disallow וה-URL שאתם רוצים לחסום.

עם זאת, חשוב לציין שפשוט להסתיר URL מ-Googlebot באמצעות קובץ robots.txt לא מבטיח שהוא לא ייאונדקס. במקרים מסוימים, URL עשוי עדיין להיות מאונדקס על סמך גורמים כמו הטקסט של ה-URL עצמו, הטקסט המקשר של הקישורים החיצוניים וההקשר של הדף החיצוני שבו ה-URL התגלה.

כיצד לבדוק את קובץ robots.txt שלי?

ניתן לאמת את קובץ robots.txt ולבדוק כיצד ההנחיות עובדות על כתובות URL ספציפיות באמצעות בודק robots.txt ב-Google Search Console או באמצעות בודקים חיצוניים, כמו זה של Merkle.

ניתן לקרוא עוד על מונחים ומושגים שונים בעולם ה seo- במילון המונחים באתר.